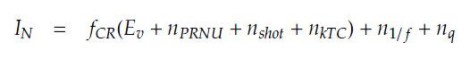

Questa settimana riprendiamo esattamente dal punto in cui avevamo lasciato nella scorsa puntata, ovvero dall’equazione che fornisce il segnale totale elaborato da una fotocamera digitale, comprensivo di rumore

dove I(N) è il segnale totale, f(CR) è la CAMERA RESPONSE FUNCTION, ovvero una funzione piuttosto complessa che tiene conto di diversi fattori come, ad esempio, la tipologia del sensore e la sua risposta alla radiazione incidente (e, quindi, di conseguenza, anche la QE del sensore in base al suo affollamento), l’algoritmo di quantizzazione utilizzato, una compressione di tipo non lineare del dynamic range.

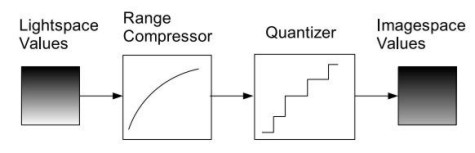

In parole povere, si tratta di una funzione che tiene conto di tutti quei parametri che permettono di passare dal LIGHTSPACE, ovvero lo spazio della “luce” incidente sul sensore, all’IMAGESPACE, ossia allo spazio dell’immagine che la fotocamera elabora partendo da quella specifica quantita di luce catturata. Come spesso avviene in fisica, nel calcolo della f(CR) si applicano delle semplificazioni, partendo dall’assunto che sia schematizzabile attraverso una cascata di due funzioni non lineari, una che attua una compressione non lineare, monotona e convessa della luce incidente e la seconda che applica una quantizzazione di tipo uniforme. Lo schema qualitativo è riportato in basso

Cerchiamo di immaginare, per un attimo, quello che avviene nel momento in cui un’immagine viene registrata su una pellicola o su un sensore digitale. La luce colpisce il soggetto e viene riflessa: parte di queste riflessioni finiscono sull’obiettivo della nostra fotocamera che ha il compito di guidarle nel miglior modo possibile, evitendo o cercando di ridurre al minimo dispersioni, rifrazioni, ecc, verso il mezzo destinato ad effettuare la cattura dell’immagine.

Questo mezzo può essere una pellicola o un sensore. Parlando di fotografia digitale, ovviamente, faremo riferimento a quest’ultimo. Il primo blocco dello schema, denominato Lightspace Value, fa riferimento proprio ai valori della luce che giungono sulla superficie del sensore o sulla pellicola. Lo spazio immagine è uno spazio non semplice da definire: verrebbe da dire che si tratta di uno spazio analogico ma, di fatto, il mezzo che viene usato per la trasmissione dei segnali, ossia la luce, è di tipo discreto.

Cerchiamo di capire, quindi, cosa avviene quando la luce, trasmessa attraverso le lenti, arriva al sensore e viene trasformata in carica elettrica; cercando di approfondire la conoscenza della struttura di un sensore è più facile capire quale sia l’origine delle diverse componenti di rumore riportate nell’equazione di inizio pagina.

Come detto, la luce è un mezzo di trasmissione di tipo discreto che porta infirmazioni di uno spazio continuo (quello delle immagini). Colpendo il fotorecettore, il fotone genera uno o più coppie elettrone-lacuna che la polarizzazione inversa della giunzione trasformerà in corrente. Questa corrente genera un accumulo di cariche all’interno di appositi buffer. Ogni pixel ha a disposizione uno di questi “contenitori” in cui viene immagazzinata la carica.

Un clock interno scandisce le fasi di inizio e fine immagazzinamento e del trasferimento di questi valori di carica verso altri stadi di elaborazione della pipeline interna ad una fotocamera. In pratica, quello che viene letto è il numero di elettroni che da ciascun pixel sono trasferiti verso i dispositivi di elaborazione.

Ad ogni fotosito corrisponde uno dei 3 valori RGB (ricordo che, in realtà i fotositi che formano un pixel sono 4 poichè ci sono 2 verdi, 1 blu e 1 rosso). Il numero di elettroni rilevato dà la misura dell’intensità luminosa che ha colpito quel particolare fotosito e il valore corrispondente del filtro utilizzato (ad esempio matrice bayer) fornisce l’informazione sul valore di crominanza di quel fotosito. Ogni pixel è ricavato come interpolazione tra i 4 fotorecettori da cui è formato.

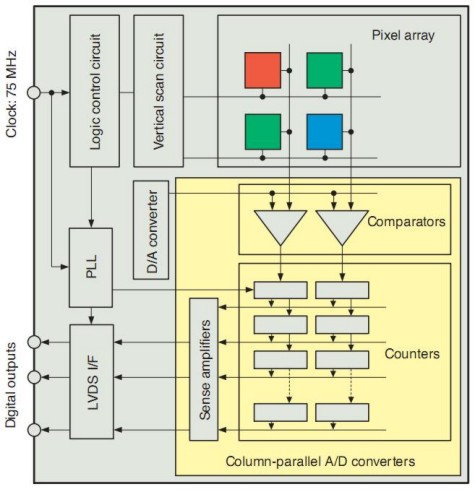

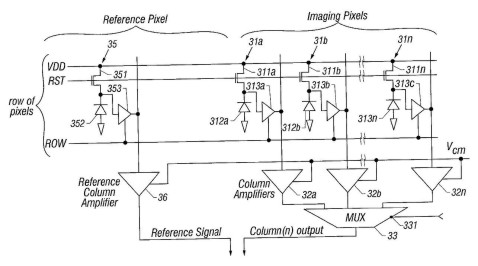

A questo punto, un dubbio è legittimo: abbiamo parlato numero di fotoni che colpiscono un fotorecettore e di numero di elettroni generati e immagazzinati in seguito a questo evento; entrambi sono grandezze discrete e non continue. Però, negli schemi dei sensori digitali vediamo che, a valle del circuiti di amplificazione del segnale c’è un circuito di conversione A/D. Ci siamo persi qualcosa? Evidentemente si e, per ritrovarla, scendiamo un po’ più nel dettaglio dell’architettura di un sensore digitale:

Lo schema in figura è quello di un sensore CMOS; si vedono chiaramente il circuito di controllo dell’array di pixel, quello che fa vertical scanning, ossia che registra le variazioni di segnale lungo le colonne verticali. Evidente anche la presenza di un circuito di tipo PLL (phase locked loop) utilizzato per agganciare la sincronizzazione delle operazioni che avvengono all’interno del sensore con la frequenza del DSP (ossia del processore) che si occupa dell’elaborazione del segnale.

Nell’immagine si nota la presenza di un D/A converter immediatamente a valle dell’array di fotodiodi e di un A/D converter prima dell’uscita (digitale) dei segnali dal sensore (ricordo che parliamo di un sensore CMOS la cui uscita è di tipo digitale).

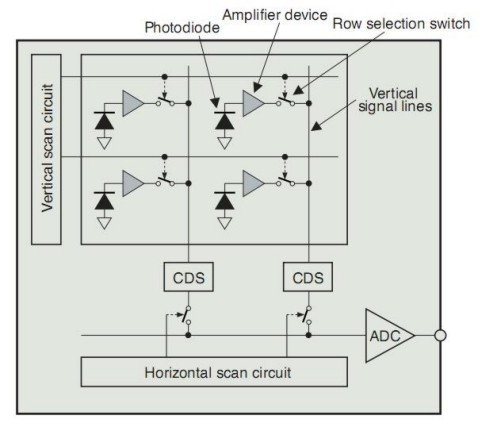

Andiamo un po’ più nel dettaglio, in particolare, della parte dove sono allocati i fotorecettori

Questo è un circuito standard di tipo CMOS. Come detto nel precedente articolo, avevamo fato cenno ad un metodo per l’eliminazione del fixed pattern noise tramite il confronto tra il livello del segnale registrato durante la fase di read out e quella di un dark frame. Questa tecnica ha un inconveniente, in quanto prevede l’immagazzinamento di un dark frame usato come termine di confronto.

Ciò si traduce in un notevole spazio di memorizzazione richiesto. In alternativa, si ricorre ad un circuito, quello indicato come CDS nella precedente figura, che legge il segnale durante la fase di reset e durante quella di read out, facendo una comparazione tra i due livelli e la relativa differenza. Questo metodo ha il vantaggio di permettere un notevole risparmio in termini di memoria, perchè prevede la comparazione su valori rilevati durante le fasi di trasferimento del segnale di un solo frame, ma ha l’inconveniente di introdurre, a sua volta, un rumore di tipo fixed pattern che deve essere filtrato, a sua volta, a valle del CDS.

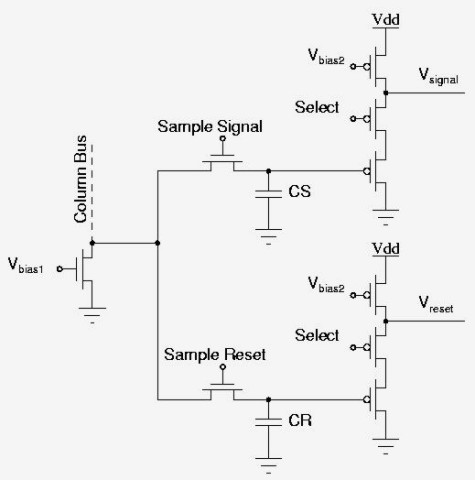

In basso, è riportato, a titolo di curiosità, uno schema di un circuito CDS

Finora abbiamo visto quale sia l’origine del dark current noise, e del blooming; oggi abbiamo modo di vedere da dove provengono altre componenti del rumore. Una di queste è il rumore dovuto alla non linearità degli amplificatori. In un CCD è presente un solo stadio di amplificazione a valle del sansore mentre su un CMOS di tipo APS, come abbiamo visto, è presente un amplificatore per ogni fotodiodo ed uno a valle del convertitore A/D.

Se da un lato questa ridondanza di amplificatori consente di compensare risposte la non uniformità di risposta dei fotositi e di miglioarre il rapporto S/N di tipo quantico, dall’altro introduce una maggior cifra di rumore da amplificazione che deve essere filtrata. Come detto, gli stessi CDS, che hanno il compito di eliminare il FPN, se da un lato assolvono piuttosto bene al loro incarico, dall’altro introducono altro rumore di tipo fixed pattern.

Anche l’operazione di trasferimento del segnale e la successiva operazione di reset introduce un rumore con pattern di tipo random, il RESET NOISE, per l’appunto, comune sia ai CMOS che ai CCD.

A questo punto, cerchiamo di ricapitolare il tutto, partendo dal dark frame, in cuii sappiamo esistere una componente di rumore dovuta alla corrente generata dalla polarizzazione inversa della giunzione p-n. Nel momento in cui l’elemento fotosensibile è colpito dalla radiazione luminosa. si formano coppie elettrone lacuna che venogno accelerate dalla polarizzazione della giunzione nelle due opposte direzioni, creando una corrente elettrica.

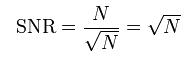

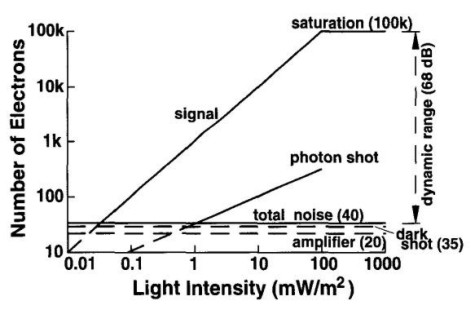

Questo processo permette la lettura dei valori dell’intensità luminosa che colpisce il singolo fotosito ma genera anche, a sua volta, rumore, detto PHOTON SHOT NOISE. Infatti l’intensità luminosa registrata, anche a parità di radiazione incidente, come tutti i fenomeni che coinvolgono un numero piccolo di eventi, presenta dslle fluttuazioni che danno origine ad errori nella rilevazione del segnale. Questi errori, al pari del segnale generato, aumentano all’aumentare del numero di fotoni che colpiscono il fotosito, secondo il rapporto riportato in basso

dove N è il numero medio di fotoni incidenti sul fotodiodo. Come si vede, il segnale cresce linearmente con il numero di fotoni incidenti mentre il rumore con la sua radice quadrata. Al crescere di N, come già visto (per comodità riporto ancora una volta il grafico)

da un certo valore in poi il photon shot noise diventa preponderante rispetto a tutti gli altri tipi di rumore random pattern.

Su un sensore di tipo MOS, il segnale viene immagazzinato, amplificato, a livello di singolo fotosito, dando origine ad una componente dell’amplifier noise, quindi trasformato in segnale elettrico per poter essere “letto” dal circuito CDS. In questa fase avviene una conversione D/A del segnale con introduzione di READ NOISE.

Tra una operazione di trasferimenot e lettura del segnale a la successiva, il sistema viene resettato introducendo, per l’appunto, il RESET NOISE. Ci sono, poi, tutta una serie di rumori introdotti dalle disomogeneità nella risposta dei singoli pixel (PIXEL WISE), nelle operazioni di trasferimento per colonna e per riga dei segnali (COLUMN E ROW WISE), che vengonofiltrati utilizzando dei gruppi di pixel come campioni e comparando il segnale di questi con quello dei pixel deputati a formare l’immagine. Questi pixel campione servono, in pratica, per effettuare una corretta taratura della risposta del sensore alla radiazione incidente. Uno schema per ridurre il ROW ed il COLUMN WISE NOISE, è riportato in basso.

Questo è anche uno dei motivi per cui un sensore presenta un numero di pixel reali sempre inferiore a quello dei fotositi da cui è composto.

L’ultimo tipo di rumore cui faremo cenno oggi è quello noto come SHADING. In effetti questo è solo uno dei tipi di rumore, generati quando la luce colpisce il sensore e dovuti al cosiddetto pixel crosstalk. Questo tipo di problema, dovuto ad interferenze tra circuiti vicini, viene acuito dall’aumentare della densità dei sensori. Questo per due ragioni: la maggior vicinanza degli elementi circuitali e la loro minor dimensione. Infatti, al diminuire delle dimensioni aumenta la vulnerabilità dei circuiti elettronici all’interferenza tra elementi circuitali che generano correnti parassite e, nel caso delle fotocamere digitali, provocano errate interpretazioni delle componenti cromatiche dell’immagine.

Per questo motivo (e per contenere gli effetti della diffrazione), quando si passa ad un processo produttivo più raffinato e si riducono le dimensioni dei fotositi, il rapporto tra dimensioni dei fotositi stessi e le loro reciproche distanze tende a diminuire. Ossia, al diminuire delle dimensioni degli elementi del circuito, calano le dimensioni del singolo fotosito e, in valore assoluto, si riducono anche le distanze tra fotositi; ma queste ultime scendono molto meno rapidamente delle dimensioni dei fotositi stessi. Quindi se, per ipotesi, fotositi di 6 micron sono distanziati di (sparo a caso) 1 micron, fotositi di 3 micron non avranno distanza pari a 0,5 micron ma, magari, di 0,7 (i numeri sono random ma spero di aver reso l’idea).

Finora abbiamo affrontato solo parte dei processi che avvengono all’interno di una fotocamera digitale e che portano alla creazione dell’immagine: quelle che nello schema di inizio pagina sono rappresentate con il blocco indicato come RANGE COMPRESSOR, di cui non abbiamo neppure analizzato tutte le caratteristiche ma ci siamo limitati a vedere alcune forma di rumore. Il segnale, a questo punto, però, non è ancora pronto per essere inviato al processore. Deve essere digitalizzato, ossia sottoposto ad un’operazioni di campionamento e ad una di quantizzazione.

Nel prossimo capitolo vedremo questo processo, parleremo del rumore che lo stesso introduce e torneremo ancora sul rumore parlando di chroma e luminance noise e di rumore in alta e bassa frequenza.