Quella che voglio condividere oggi con voi, è una puntata della favolosa serie di approfondimenti tecnologici Computer Chronicles (di cui abbiamo già parlato qui).

Il tema è quello dei computer usati, l’anno è il 1986. Stewart Cheifet, assieme al co-conduttore Gary Kildall, s’interrogano sul fenomeno dei PC usati, su quali siano i criteri per evitare bidoni, di come metterli alla prova.

Siamo, è bene ricordarlo, a un ventennio di distanza dalla consumerizzazione del PC, dall’abbattimento dei suoi prezzi fino a un livello sostenibile solo da pochi, enormi colossi del far east. Molta parte dell’hardware è ancora costruita negli USA o in Europa, mentre “taiwanese” o “giapponese” è sinonimo di bassa qualità e scarsa affidabilità.

Partecipano alla trasmissione esperti del settore, fra cui alcuni imprenditori coinvolti nella vendita di computer usati. Uno di loro, mette a disposizione dell’utenza una sorta di antesignano di ebay su BBS: un catalogo di sistemi usati, finanziato da una percentuale degli introiti da vendita.

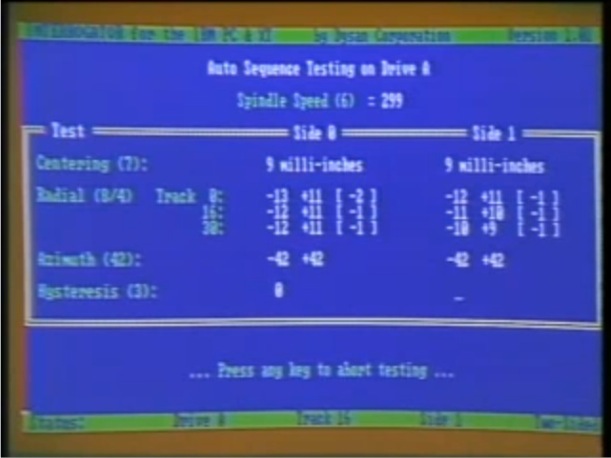

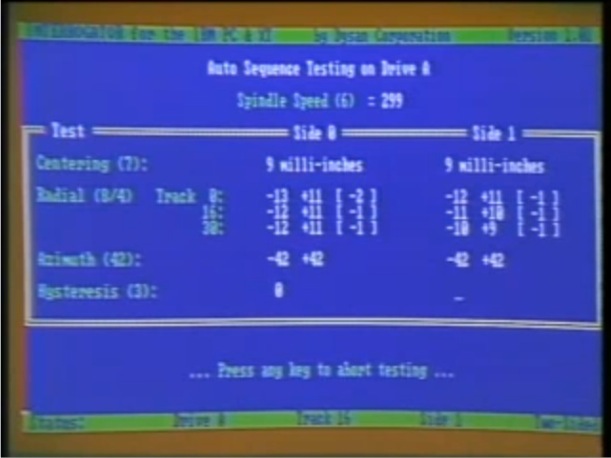

La puntata mi ha trascinato dietro di quindici anni abbondanti, con dimostrazioni di programmi per controllare l’allineamento delle testine del floppy, diagnostici per individuare chip RAM difettosi, test “burn-in” per garantire l’affidabilità dell’elettronica.

Test che avevano perfettamente senso in un’epoca in cui il prezzo di un computer nuovo era ancora proibitivo, e l’acquisto di sistemi usati una scienza custodita da pochissimi.

Piccola nota di folklore: un operatore nel settore dei sistemi usati, interpellato su quale computer fosse più difficile da vendere, risposte seccamente – alla presenza dello stesso Kildall, che non se ne adirò – rispose: plain vanilla CP/M machines, ovverosia i sistemi che eseguono il solo CP/M.

Ho notato questa frase e ve la riporto, perché conferma che già nel 1986, il predominio di MS-DOS era di fatto sancito nel segmento business (che comprendeva anche un’ampia fetta di pubblico interessato alle stesse funzioni disponibili presso il computer dell’ufficio).

Più specificamente, il binomio Microsoft-Intel era già – benché dietro le quinte – al comando del mercato, a suon di accordi marketing con produttori di cloni da tutto il mondo, per la vendita di hardware e software del tutto identici a quelli forniti a IBM.

Se ne sarebbe accorta presto, e a sue spese, la stessa Big Blue, per la cui divisione PC andava preparandosi un futuro tetro, fatto di progressiva perdita di quote di mercato, corsa al ribasso dei prezzi, fino alla vendita dell’intera divisione a Lenovo nel 2004.

Era appena l’alba di quell’epoca di “dittatura della compatibilità” che di certo agevolò la costruzione di un terreno comune – sebbene carico zavorre legacy – su cui costruire applicazioni, ma lo fece sbarrando il cammino ad architetture molto più efficienti.