Nel lontano 1996 la rivoluzione della rete, benché ancora in fase embrionale, mostrava di avere un’enorme influenza sull’ancora turbolento mondo del personal computer. Con Windows 95 – primo capitolo dell'”epoca imperiale” del personal computer – fresco di lancio, alcune piattaforme alternative, superstiti del boom dell’IBM compatibile, si contendevano ancora un mercato in piena esplosione, prima che lo schiacciasassi Wintel cancellasse la concorrenza con montagne di budget marketing e una discreta serie di colpi bassi.

Erano gli anni in cui l’Apple Pippin, un Macintosh in rapido declino (in un certo senso anche il BeBox con un accento sulla multimedialità) e una pletora di apparati di convergenza – fax evoluti con accesso web, set top box etc. – cercavano di sfruttare la rivoluzione della rete come trampolino per il lancio di una nuova generazione di sistemi, più “Internet friendly” dei tradizionali PC – oggetti nati su tutt’altro scenario ed evolutisi linearmente per un decennio abbondante.

Proprio nel 1996, un anno in cui di Internet si parlava molto e quasi sempre a sproposito, vide la luce il Network Computer di Oracle, il quale più che un nuovo PC, rappresentava un nuovo paradigma, una soluzione innovativa e Internet-centrica al tema del personal computing.

In questo afoso venerdì di agosto, per i più ultima tappa delle sudate ferie, riapriamo il sempre verde filone della nostalgia informatica, analizzando perché e percome di uno dei più rumorosi flop dell’epoca tecnologica moderna.

Un flop dietro cui si cela tuttavia il vero antesignano di un modello computazionale – diametralmente opposto a tutto ciò che il PC fino ad allora significava, e per un altro decennio abbondante avrebbe significato – che oggi sembra pronto per un ritorno in larga scala: il cloud computing.

Il Network Computer è un formato concepito dalla Oracle del vulcanico Larry Ellison (in un’alleanza con Sun, l’arcirivale IBM, nonché Apple e Netscape), per contenere drasticamente i costi di produzione e catturare in questo modo una grossa fetta dell’espansione che il mercato PC andava conoscendo.

Il concetto alla base del NC affonda le radici nel mondo dei mainframe, sistemi enormi e costosissimi le cui risorse di calcolo venivano fruite tramite l’uso di terminali “stupidi” (dumb), ossia privi della logica necessaria a funzionare autonomamente ed operanti solo come interfaccia remota del mainframe stesso.

NC non è dunque altro che un’incarnazione del concetto di thin client, nella fattispecie un sistema non del tutto “stupido” ma privo di alcune componenti per contenere i costi. NC era infatti privo di hard disk e conteneva solo il software necessario per la gestione delle periferiche e l’accesso alla rete. Una volta avviato e connesso, NC poteva dunque contare su risorse disponibili su server remoti sia per l’esecuzione di applicazioni, sia per lo stoccaggio d’informazioni.

Un approccio diametralmente opposto alla forma che andava assumendo il PC – in cui l’enfasi sul “ferro” rimaneva forte e tutte le risorse erano disponibili localmente – che voleva rinnovare, facendo perno su Internet, concetti appartenenti agli albori dell’informatica, quando l’hardware necessario alla computazione aveva costi ed ingombri proibitivi per un uso privato.

Le analogie con il moderno concetto di cloud computing sono notevolissime, a dimostrazione della validità dell’idea (o della persistenza di una volontà di sovversione dell’ordine costituito, perlopiù Microsoft-centrico, del mercato PC). Non è d’altronde un caso che, a concepire questo genere di appliance, sia stato un colosso del software come Oracle: una volta piazzato un terminale a basso costo in ogni casa, si sarebbe potuto lavorare sulla vendita di vari livelli di servizio software, erogati da remoto, con potenziali buone economie di scala.

Come prodotto ma soprattutto come paradigma, NC rappresentava un vero “colpo di stato” ai danni delle due aziende che già nel 1996 si profilavano come i monarchi del mondo PC: Microsoft e Intel (le quali non a caso misero a punto un formato alternativo, il NetPC).

Appaltata la produzione di hardware ad aziende partner (cui si richiedeva solo l’aderenza ad alcune specifiche tecniche), la prima si sarebbe trovata privata del mercato su cui collocare OS e applicazioni, essendo questi ultimi veicolati come servizio dal consorzio a lei avverso, e la seconda avrebbe visto tramontare le fiorenti prospettive di un mondo PC fortemente hardware-centrico per essere eventualmente relegata alla produzione di componenti di basso costo e bassissima redditività.

Manco a dirlo, Network Computer e il suo omologo NetPC, primi tentativi dell’industria di imporre il modello thin client, fallirono su tutta la linea. Dal punto di vista culturale, il mercato di riferimento non era ancora pronto ad accettare questo cambio di paradigma, come dimostrano i molti anni successivi in cui il client andò ingrassando più che dimagrendo, trasformandosi in un sempre più un pasciuto feticcio mangiawatt.

Dal punto di vista economico poi, il risparmio determinato dall’assenza dello storage locale e del software, fu ben presto superato dal rapido crollo dei prezzi dell’hardware, parallelo al boom di vendite del PC successivo al lancio di Windows 95 e successivi.

Anche dal punto di vista tecnico, a causa di limitazioni infrastrutturali (le connessioni più diffuse nel 1996 erano dial-up da 14,4 o 28,8 Kbps, con la ISDN a 64 Kbps che rappresentava per i più solo un sogno erotico) e dello stadio ancora involuto del web per l’erogazione di servizi complessi on-line, il progetto mostrò fortissimi limiti, che ne decretarono in ultima analisi la fine all’alba del nuovo millennio, fra basse vendite e continue revisioni delle specifiche (compreso, guardacaso, l’ingresso di hardware targato Intel).

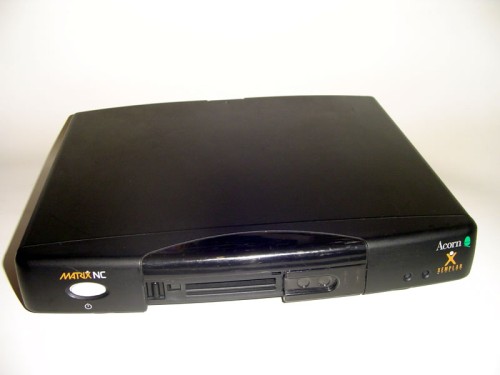

Del NC ai posteri rimangono cimeli perlopiù inutilizzabili quali l’Acorn Network Computer – prima implementazione delle specifiche NC – ed altri modelli di IBM (inizialmente basati su PowerPC, poi su Pentium) e Sun, ma soprattutto alcune notevoli analogie con la pluri-annunciata-come-imminente transizione al cloud computing

Una transizione che ancora una volta, malgrado l’evoluzione delle tecnologie di base, va a scontrarsi con un residuo e per nulla marginale feticismo per l’hardware, una non del tutto infondata diffidenza nei confronti della consegna dei propri dati ad infrastrutture remote e, non ultima, l’abitudine alla fruizione di applicazioni in locale molto più ricche e funzionali di quanto non si siano dimostrate finora quelle web-based.

A tutto questo si somma oggi un non trascurabile problema di sostenibilità economica (già brevemente accennato): con gli ISP già messi alla frusta dall’avvento dello streaming video su larga scala, i produttori di hardware chi più chi meno ridotti a lavorare su margini da fame e una grandissima ricchezza ancora orbitante attorno alla produzione di software concepito per una fruizione in locale, il cloud computing e il SAAS potrebbero risultare un magro affare per tutti i soggetti che dovrebbero promuoverli, con la notevole eccezione di una certa G.