Inizio con un commento più mondano, che però non riesco a trattenermi dal fare. Mi riferisco ovviamente al comunicato della ministra Gelmini, ma non necessariamente al suo svarione sul tunnel.

Quello è chiaramente un sintomo non solo di ignoranza, ma anche una prova del disinteresse che l’intero governo, e soprattutto il ministro dell’istruzione, ha nei confronti della ricerca scientifica. Quello che mi ha dato più fastidio del comunicato, però, non è il tunnel, ma l’atteggiamento di chi vuole saltare sul carro dei vincitori senza nemmeno sapere di che partita si sta parlando.

Prima di tutto cercando di inserire un “prezzo”, pagato dal governo, per finanziare questa scoperta. In secondo luogo la frase “Il superamento della velocità della luce è una vittoria epocale per la ricerca scientifica di tutto il mondo “. Ma la signora Gelmini crede che si tratti di una specie di corsa di cavalli? I ricercatori italiani sono riusciti a fare andare i propri cavalli più veloci, quindi hanno vinto! In ultimo, vorrei far notare che questa grande fierezza del governo è del tutto mal posta. L’analisi in se per se è stata sviluppata da un gruppo di Lione, non da un gruppo italiano (sebbene ci siano in quel gruppo ricercatori italiani, fuggiti dalla Gelmini e compagnia bella).

E questo, di per sé non è importante. Ma quello che è importante è che moltissimi ricercatori e professori (tra cui il portavoce dell’esperimento Opera, il prof. Antonio Ereditato) devono svolgere le loro ricerche dall’estero, visto che in Italia è impossibile avere uno stipendio sufficiente per automantenersi o avere condizioni di lavoro vagamente appaganti. Quindi, perdonatemi questo sfogo, ma la Gelmini non è da criticare (solo) per la gaffe sul tunnel, ma soprattutto per il tono mussoliniano in cui annuncia una vittoria che non c’è, o almeno non per le cose che spera lei.

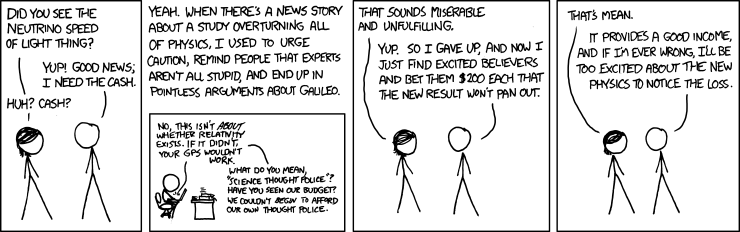

Ma torniamo alla scienza. Quello che vorrei cercare di evitare di fare è quello che molti fisici sono tentati di fare (me compresa), ovvero seguire il comportamento consigliato da questo fumetto:

Ma veniamo al sodo. Opera è un esperimento il cui obiettivo principale è misurare l’oscillazione (ovvero la trasmutazione) di un neutrino della famiglia dei muoni in un neutrino della famiglia Tau. Non mi dilungherò su questo argomento, perché ne ho già parlato in un post di circa un anno fa (che suggerisco di rileggere), quando Opera ha osservato il primo neutrino tau.

Come analisi secondaria, alcuni scienziati di Opera hanno sviluppato un metodo di misura della velocità del neutrino, misurando il tempo di percorrenza (o TOF, time of flight, come si dice in termini scientifici) tra il momento della produzione e della rivelazione. L’idea di effettuare questa misura non è nuova. Un’analisi simile, con un risultato simile, è stata fatta dall’esperimento MINOS, al Fermilab vicino a Chicago. Il loro risultato è stato pubblicato ed è disponbile in accesso libero qui. La principale differenza è l’errore di misura. L’errore (sistematico e statistico) con cui MINOS ha fatto questa misura è così elevato da rendere difficile poter gridare “alla scoperta”. Il punto chiave è infatti questo: con quale precisione si riesce a capire la posizione e il momento in cui i neutrini sono stati prodotti al CERN e quando hanno interagito nel Gran Sasso?

Opera si trova in una situazione vantaggiosa, da questo punto di vista. Il rivelatore è composto fondamentalmente da una serie di “mattoni” di piombo, combinati assieme da delle emulsiioni fotografiche. Quando il neutrino passa e interagisce con uno dei nuclei del piombo, un complesso sistema computerizzato di tracciamento della traiettoria delle particelle uscenti permette di ricostruire il punto e il momento esatto dell’interazione. La precisione di misura del punto di interazione è quindi estremamente elevata.

Non basta però. Servono ancora due ingredienti per poter conoscere la velocità del neutrino. Bisogna ancora sapere il momento e la posizione in cui sono stati prodotti e, non dimentichiamolo, l’esatta distanza che hanno percorso tra il Cern e il Gran Sasso. Questa ultima misura, come è stato abbondantemente spiegato nel seminario che stato dato al Cern venerdì scorso, è stata effettuata con particolare attenzione. Il gruppo di geodesia dell’Università della Sapienza a Roma ha contribuito a questa misura e, tra considerazioni di geodesia e misure fatte con il satellite GPS, sono riusciti ad ottenere una precisione di 20 cm (su una distanza approssimativa di 730 km!). Ma veniamo al punto veramente più problematico e controverso di tutta l’analisi. Il punto di creazione dei neutrini.

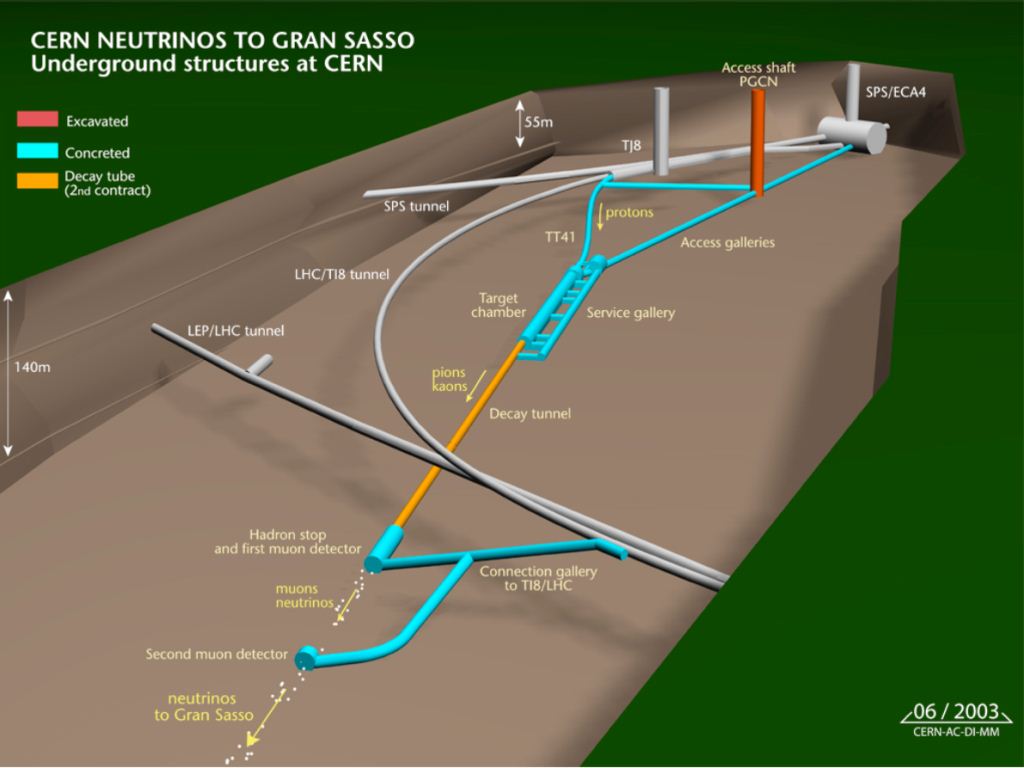

Per generare neutrini purtroppo non possiamo spemplicemente premere un pulsante e generare un fascio puro e uniforme. I neutrini vanno creati a partire da ciò che abbiamo: i protoni. Il progetto CNGS (CERN Neutrinos to Gran Sasso) ha lo scopo di generare un fascio di neutrini a partire dai protoni accelerati nell’acceleratore SPS del CERN e incanalarli in direzione del Gran Sasso, come mostrato nella figura seguente:

I protoni si presentano sotto forma di “pacchetti” che vengono accelerati fino ad un’energia di 400 GeV (6.41 × 10-8 joules). La grandezza di questi pacchetti è variabile, anche se centrata attorno ad un valore medio. Questi pacchetti di protoni, che girano attorno all’acceleratore, vengono estratti in due momenti dal flusso, e inviati verso un bersaglio di grafite lungo 2 metri, per la generazione di neutrini. I protoni, interagendo con la grafite creano “pioni”. Questi pioni decadono presto in muoni, e i muoni decadono a loro volta in elettroni e neutrini. Questo procedimento genera un fascio di neutrini muonici con un’energia media di circa 17 GeV, con una certa contaminazione di neutrini elettronici. I pioni vengono focalizzti da dei magneti e percorrono un “tunnel di decadimento” lungo 1000 m.

Come è facile immaginarsi, capire la struttura fine dei pacchetti di protoni e del risultante fascio di neutrini non è affatto facile. Innanzi tutto, non tutti i protoni interagiscono e producono neutrini. La grandezza del pacchetto di protoni è variabile e anche se statisticamente centrata può avere delle code anche molto lunghe. Per questa ragione è assolutamente improponibile fare una misura di tipo “deterministico”, mettendosi con un cronometro da una parte e dall’altra del “tunnel”:-P

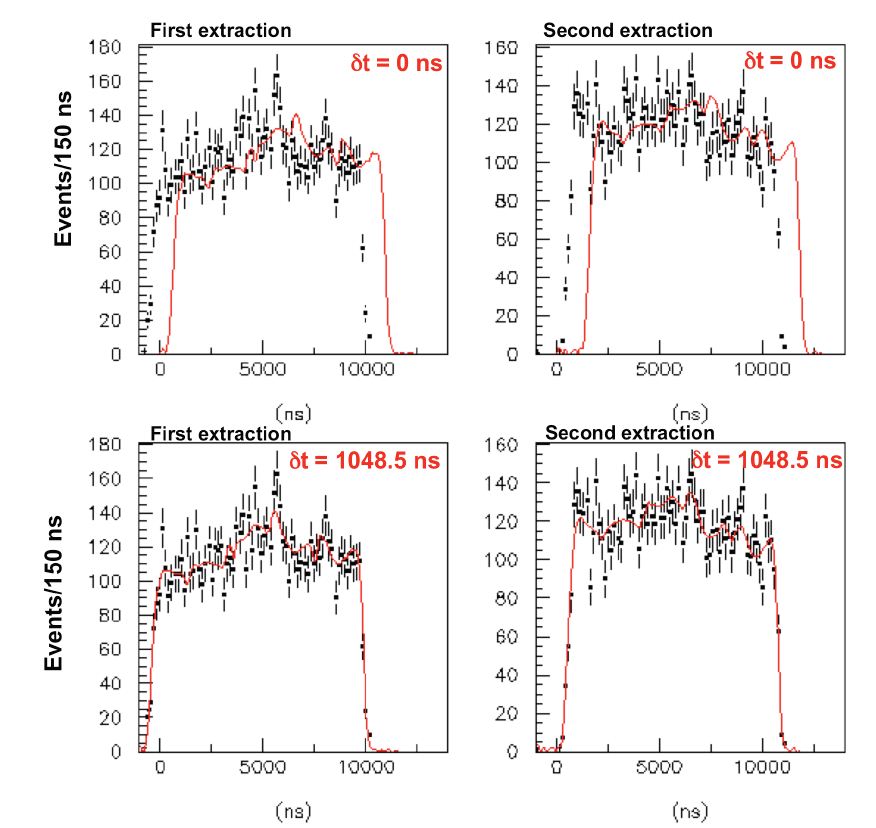

L’unico modo per comparare il momento di produzione dei neutrini e il loro momento d’arrivo è fare un’analisi statistica delle funzioni d’onda iniziali e finali. Per fare questo si deve prima di tutto definire una PDF (ovvero una Probability Density Function) che è una distribuzione di probabilità che mi dice quanto probabile è che un protone si trovi in un certa posizione ad un certo tempo. Le funzioni d’onda iniziali vanno quindi confrontate con il momento della misura del neutrino al Gran Sasso, e si deve capire se c’è uno spostamento sistematico o meno. Poiché l’estrazione dei protoni dal fascio del SPS viene fatta due volte, questo procedimento va svolto separatamente nei due casi.

Per fare questo confronto si è fatto uso di una simulazione Monte Carlo, ovvero un software che, facendo uso di un generatore di numeri casuali, cerca di riprodurre la statistica osservata nel sistema. Sono stati prodotti diversi “sistemi Monte Carlo”, ciascuno corrispondente a un determinato “anticipo” del neutrino rispetto al momento aspettato se viaggiasse alla velocità della luce. Questi intervalli di tempo sono stati considerati sempre costanti, non è quindi stata presa in considerazione la possibilità che la velocità del neutrino variasse (nel tempo o con diverse energie, per esempio). Il grafico qui sotto mostra questo confronto tra il momento misurato dell’arrivo del neutrino (i punti in nero) e la distribuzione di probabilità dei protoni (in rosso):

si vede quindi che aggiungendo un intervallo di tempo di 1048.5 nanosecondi, le due curve sono compatibili l’una con l’altra. Questo risultato, una volta che vi si aggiungono gli errori sistematici sulle misure della distanza e del tempo spiegate prima, porta a una variazione della velocità dei neutrini misurata (v) rispetto alla velocità della luce (c) di:

(v-c)/c = (2.48 ± 0.28 (stat.) ± 0.30 (sys.)) ×10 -5

che altro non è che il risultato che ha suscitato tutto questo polverone mediatico.

Vorrei aggiungere ancora due cose se mi perdonate il post chilometrico.

1. La ragione del polverone

2. La mia opinione su questo risultato

La ragione del polverone mediatico è molto semplice. Un risultato di questo tipo può avere conseguenza enormi sulla nostra concezione della fisica, costringendoci a rimettere in gioco quasi tutto. Per questo motivo la collaborazione OPERA non cerca di dare nessun tipo di interpretazione fenomenologica o filosofica a questo risultato. Della serie, noi abbiamo fatto questa misura, che cosa vuol dire lo devono capire i teorici. Ora, credo che se gli scienziati che hanno fatto la misura prendono questa posizione cauta e conservativa, lo dovrebbero fare anche tutti i giornali e tutti quelli che vengono fuori con teorie strampalate che vogliono dimostrare che Einstein era un fallito.

Queste misure vanno prese in serissima considerazione, ma azzardare interpretazioni e conclusioni prima che sia veramente possibile farlo è folle. Per questo la collaborazione di OPERA ha giustamente deciso di uscire dalla classica prassi di passare attraverso la peer review prima di presentare il risultato, ma lo ha reso subito disponibile online e lo ha illustrato in un seminario al CERN (per farlo in genere i lavori devono essere già pubblicati). Questo per dare modo all’intera comunità scientifica (e soprattutto a chi lavora in simili esperimenti) di rifare la stessa misura per confrontarne il risultato. Ovviamente, il lavoro verrà anche sottomesso a peer review prima di venir pubblicato su una rivista scientifica, anche perché alcuni membri della collaborazione non hanno condiviso questa decisione e hanno rimosso i propri nomi dall’articolo presentato su ArXiv.

La mia personale opinione su questa analisi. Ci tengo a dire che è la mia opinione personale e non ritengo di essere nella posizione di giudicare gli altri, ma faccio un’osservazione di cui mi piacerebbe discutere con chi ha fatto l’analisi. Io ho la netta sensazione che il loro risultato si basi sulla specifica forma della PDF che è stata analizzata con il metodo della Maximum Likelihood. Come si vede dai grafici sopra (guardiamo quelli in basso per semplicità), la parte centrale è abbastanza piatta, tutto un su e giù n cui si può fittare praticamente tutto.

La forma della funzione di probabilità (quella rossa) è soprattutto data dai punti laterali, quelli ai due estremi. Questo vuol dire che l’intero risultato (ovvero lo shift necessario per far combaciare le due curve) è fondamentalmente basato solo su una manciata di punti, riducendo la significatività del risultato finale (secondo me). Infatti come sarebbe cambiato il risultato se un paio di quei 5-6 punti fossero stati solo leggermente spostati? Sarebbe cambiato probabilmente molto. La differenza è che il risultato ha una significatività altissima (6 sigma0 perché vengono considerati tutti i punti nei plot. Ma se uno dei punti centrali cambiasse leggermente posizione, probabilmente non ce se ne accorgerebbe nemmeno. Al contrario, quei pochi punti laterali hanno grande importanza. Questo mi fa pensare che una qualsiasi imprecisione nella modellazione dei pacchetti di protoni fatta inizialmente potrebbe effettivamente far cambiare radicalmente il risultato.

Ripeto che questa è solo la mia opinione, e il punto che più mi incuriosisce di questa analisi.

Un’altra osservazione è che la velocità dei neutrini è stata misurata con estrema precisione anche dall’esperimento Superkamiokande, in Giappone, osservando i neutrini prodotti dall’esplosione della supernova SN1987a e confrontandoli con i dati dei telescopi che hanno osservato la supernova nel visibile. In quel caso i neutrini si sono comportati benissimo, andando alla stessa velocità della luce. Si può pensare che la ragione di questa discrepanza sia la diversa energia dei neutrini, e che quindi i neutrini più energetici prodotti al CERN vadano in effetti più veloci dei neutrini con più bassa energia prodotti nelle supernovae. Questa possibilità, però, non è ancora stata dimostrata, né OPERA è riuscita a dimostrare nessuna correlazione tra la velocità dei neutrini e la loro energia iniziale. Chi, quindi, avrà ragione?

Per chi si fosse perso la diretta, è possibile guardare la presentazione fatta al CERN dal ricercatore del gruppo di Lione che ha presentato l’analisi a questo indirizzo.