Qualche giorno fa è comparsa su Reuters una strana e intrigante notizia a proposito di Intel, secondo la quale il colosso californiano potrebbe cominciare a produrre processori non-Intel. Leggendo la notizia si capisce che le cose non stanno esattamente così — ma come stanno allora? Qual è il significato di questo annuncio, a chi si rivolge, e cosa potremmo aspettarci in futuro?

Dopo un iniziale sbalordimento, e un po’ di riflessione, la cosa ha cominciato ad avere senso — anzi, ad essere perfettamente logica. Credo che questa decisione sia la fava con cui Intel cerca di prendere due piccioni: il dominio assoluto di ARM nel segmento tablet e smartphone, e il costo stratosferico delle nuove linee produttive.

Best actor in the mobile market, and the winner is…

ARM. Il segmento smartphone e tablet, rilanciato da Apple con iPhone e iPad, è il dominio incontrastato della piccola casa britannica. Ci sono molti produttori, ma tutti usano core ARM standard (Tegra2/3, OMAP4 e Apple5 usano A9, Tegra4 e OMAP5 useranno A15) o core sviluppati in proprio basati su ISA ARM (Qualcomm con Snapdragon /Krait, NVidia con Denver).

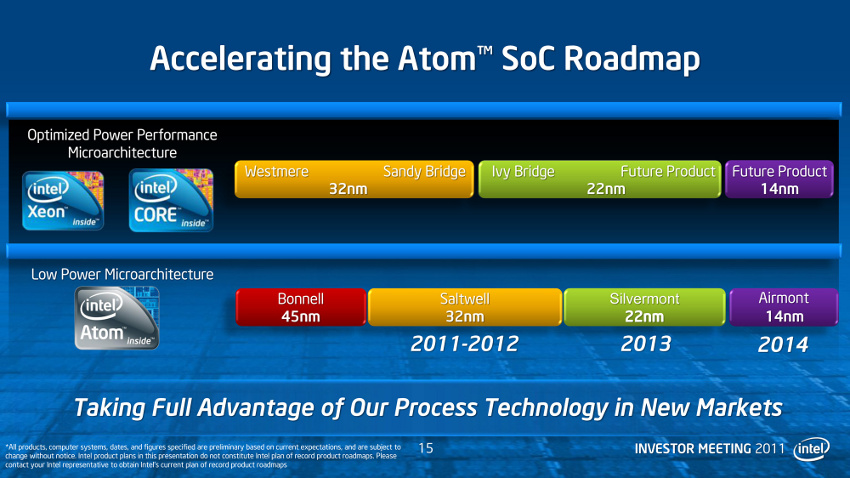

Atom ha prestazioni superiori a tutti questi ma ha consumi troppo elevati per entrare in quel mercato, oltre che prestazioni grafiche troppo scadenti. Intel ne è ben conscia e infatti ha recentemente premuto l’acceleratore sul suo programma ultra-mobile, passando da una architettura ogni 5 anni ad una all’anno e allineando il processo produttivo a quello più sofisticato usato per i “fratelli maggiori” della famiglia Core.

E’ anche possibile che il recente abbandono del capo del settore ultra-mobile sia legato al fatto che Intel ha completamente perso la prima ondata della rivoluzione mobile.

A parità di processo produttivo i processori ARM vincono nettamente la gara dei consumi (a basse prestazioni), ma Intel ha dalla sua un’arma molto potente: è, da parecchi anni, un nodo litografico avanti rispetto al resto del mondo. Un Atom in tecnologia più raffinata potrebbe cancellare il vantaggio architetturale di ARM e aprire la strada al dominio Intel anche nel segmento mobile.

Questo potrebbe andare bene per la maggior parte dei produttori, ma non per, ad esempio, Apple. Apple è l’unica a progettare l’intero ecosistema da sè, dal processore al tablet al sistema operativo. Apple potrebbe non essere interessata a comprare una soluzione Atom “made in Intel” a scatola chiusa: uno dei vantaggi di ARM, oltre ai consumi, è che è possibile comprare solo il core sotto forma di “macro” e istanziarlo all’interno del proprio design, accoppiandolo a qualsiasi altro componente si voglia (GPU, periferiche, eccetera). Questa possibilità di personalizzazione è un grosso punto di forza; Intel potrebbe replicarla e poi rilanciare con la sua capacità produttiva: “se compri il nostro core Atom puoi usarlo per costruirti il tuo System-on-Chip, e poi ti fabbrichiamo l’intero SoC nel processo più avanzato del mondo”.

Questa è decisamente una proposta allettante. Se funzionasse, Intel potrebbe portare la sua architettura anche nello spazio mobile tramite o i suoi propri SoC, o mettendo i propri core dentro i SoC degli altri. Un doppio fronte di attacco che potrebbe mettere ARM in seria difficoltà.

Naturalmente, Intel non vuole trasformarsi in una TSMC qualsiasi e mettersi a produrre i chip di chiunque: ha un vantaggio tecnologico enorme e non ha alcun interesse a condividerlo con nessuno. Citando dall’articolo della Reuters:

“Then you get into the middle ground of ‘I don’t want it to be a IA core, I want it to be my own custom-designed core,’ and then you are only getting the manufacturing margin, (and) that would be a much more in-depth discussion and analysis.”

che si traduce in italiano con “ci mettemo a produrre CPU dei nostri concorrenti dopo che sarà congelato l’inferno” :)

Non vedremo quindi, purtroppo, un Bulldozer a 22nm l’anno prossimo, nè una GPU NVidia Maxwell a 14nm nel 2014.

To Fab or not to Fab, questo è il problema

Le Fab costano tanto.

Scusate, ho sbagliato: volevo dire che costano TANTO.

Una Fab moderna, con processo sotto i 40nm e wafer da 300mm2, ha un costo di costruzione di qualche miliardo di dollari (indicativamente da 2 a 7, a seconda della dimensione), più qualche centinaio di milioni l’anno per mantenerla in attività (solo la bolletta della luce sono svariate decine di milioni). Per essere competitiva deve sfornare una quantità enorme di wafer — e quindi di chip. E’ interessante fare un paio di rapidi conti per avere un ordine di grandezza; prendiamo come esempio Intel e le sue Fab più recenti (32nm) con cui produce i Sandy Bridge:

- una Fab produce qualche decina di migliaia di wafer al mese (non ho trovato numeri per le Fab Intel, ma in genere viaggiano tra i 20mila e i 60mila)

- Intel ha circa 3 Fab con processo a 32nm e wafer da 300mm, che si traduce in un 100-200mila wafer al mese, cioè 1-2 milioni l’anno (1 milione di quei wafer sono 71mila metri quadrati! insieme a tutte le altre Fab che ha, Intel potrebbe arrivare intorno al chilometro quadrato di silicio cristallino lavorato all’anno!)

- su un wafer da 300mm ci stanno qualcosa come 300 chip da 200mm2 (che è l’area di un Sandy Bridge a 4 core)

Totale: una mezza miliardata di CPU l’anno, solo con le Fab nuove!

La domanda sorge spontanea: a chi li vendiamo questi chip? Una volta messe nel conto tutte le altre Fab con processi produttivi più vecchi, e anche considerando che Intel produce non solo CPU ma anche GPU integrate, chipset, moduli wifi eccetera… ci sono solo 7 miliardi di persone al mondo, e forse meno di 2 miliardi che possono partecipare a questo festino ad alta tecnologia.

Con i prezzi astronomici che hanno, le Fab non possono restare inattive: devono lavorare giorno e notte e devono saturare le linee. Come fare? Non è un mistero che AMD non ce l’ha fatta più, pochi anni fa: non riuscendo a saturare le sue Fab coi propri prodotti ha dovuto scorporarle in GlobalFoundries in modo da produrre chip per clienti terzi e mantenere le linee sempre piene. Anche STMicroelectronics ha pian piano iniziato a chiudere Fab, e gli altri grossi player non le hanno nemmeno mai avute (NVidia, Qualcomm).

Intel è rimasta monolitica, con le Fab più efficienti del mondo e il processo produttivo più avanzato. Ma fino a quando? Risposta: fino a… ieri. Già a fine dell’anno scorso c’erano state le prime avvisaglie, quando Intel ha cominciato a produrre chip per aziende non in competizione diretta (FPGA).

E ora, questo annuncio. Credo che Intel stia cominciando a sentire la pressione della gestione di Fab così grosse e costose. Produrre SSD potrebbe essere un modo di consumare un po’ di quei milioni di wafer, ma gli SSD hanno margini di guadagno molto più bassi rispetto alle CPU. Per continuare a mantenere le linee piene di prodotti redditizi, Intel deve riempirle con altre CPU. Piccole. Mobili. Anche a costo di vendere solo il core e lasciare agli altri la possibilità di metterci intorno il proprio SoC.