Si scatta una foto inclinando il busto verso sinistra ma tenendo la camera parallela al terreno, poi si fa uno scatto a vuoto, poi una foto piegando il busto a destra. Se tutto è realizzato con cura, dentro all’occhiale si avrà la sensazione di guardare la scenda in 3 dimensioni, per via della somma prospettica dei due scatti. ”

E figuriamoci se la tecnologia non ha già surclassato questo vecchiume” gli ho detto. Detto fatto!

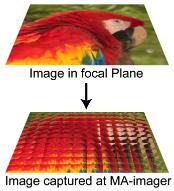

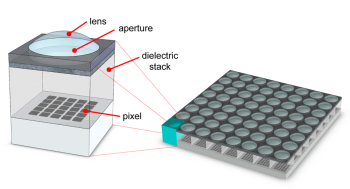

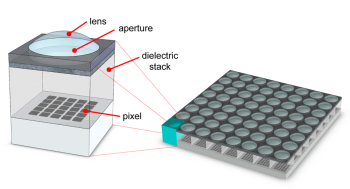

L’università di Stanford sta mettendo a punto un chip in grado di calcolare autonomamente la distanza del soggetto ripreso dalla fotocamera, e secondariamente di scattare foto con una tridimensionalità oggi sconosciuta. Invece di scattare una sola, singola, fotografia, il sensore messo a punto da Keith Fife e dai suoi colleghi, divide l’immagine in un mosaico di immagini da 16 x 16 pixel, chiamate subarray.

Ogni subarray ha la sua lente e perciò registra informazioni lievemente differenti dai suoi vicini (ad esempio può capire se un punto fa parte della maglietta del soggetto o del muro alle sue spalle). Queste informazioni sono poi usate in fase di postproduzione per ricomporre l’immagine in forma tridimensionale. In aggiunta a questa feature parecchio interessante – quantomeno in alcuni ambiti lavorativi se non nel campo della fotografia professionale pura – il chip in questione promette di ridurre il rumore digitale perché sarà più semplice distinguere se un colore fa parte del soggetto principale o no, e quindi si potrà tarare la foto di conseguenza.

Certo, essendo ancora un prototipo non è tutto oro quel che luccica, e ci sono alcuni svantaggi:

- la risoluzione del sensore è per forza di cose minore di quanto sarebbe possibile ottenere sulla stessa superficie di chip

- la postproduzione dell’immagine richiede dieci volte il tempo normale di elaborazione di una foto classica

- una fotocamera così equipaggiata consuma molta più energia di una tradizionale

- le immagini 3D sono possibili solo con soggetti che hanno del dettaglio addosso, colori, contrasti. Fotografando un muro bianco non c’è possibilità che la camera capisca a che distanza sia.

E inoltre, aggiungo, è impossibile in questo modo fotografare soggetti in movimento. Il che come detto poco sopra limita – e non di poco – l’utilizzo in ambito creativo di un chip come questo. Ma il progresso avanza, e non vedo l’ora di raccontarlo a mio zio…