Nell’ultima parte avevamo affrontato l’argomento relativo agli errori introdotti in un processo di quantizzazione reale. Avevamo anche visto che, per quanto sia possibile eliminare o ridurre alcune componenti del rumore, sia fondamentale avere, anche in ingresso al quantizzatore, un buon livello del SNR.

Nelle precedenti puntate avevamo anche analizzato, in breve, le diverse componenti del cosiddetto “rumore digitale”, avendo cura di suddividerle in base al tipo di pattern e allo stadio dell’elaborazione in cui quel particolare tipo di rumore è generato. Quello che ancora non è stato analizzato, ma solo accennato, è che la percezione del rumore stesso varia a seconda che lo stesso sia imputabile alle cosiddette componenti di crominanza oppure alla luminanza; così come non è ancora stato analizzato l’impatto che il rumore stesso ha, sulla qualità dell’immagine, al variare della frequenza. Questo è quello che, molto in breve, ci proponiamo di fare in questa puntata che è anche l’ultimo capitolo dedicato al rumore digitale.

Iniziamo, dunque, col parlare del rumore generato dalle “componenti cromatiche” e dall’intensità della luce incidente. Il primo è dovuto ad errori nell’interpretazione del corretto valore del colore in un determinato pixel o su un certo insieme di pixel: le cause sono da ricercarsi in una o più componenti di “rumore” tra quelle viste nelle precedenti puntate. La seconda, invece, deriva dalle fluttuazioni dell’intensità luminosa per pixel ed è attribuibile, in massima parte, al photon shot noise.

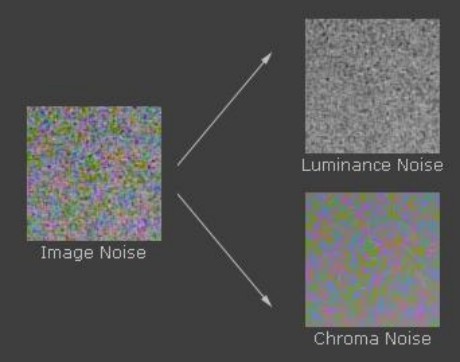

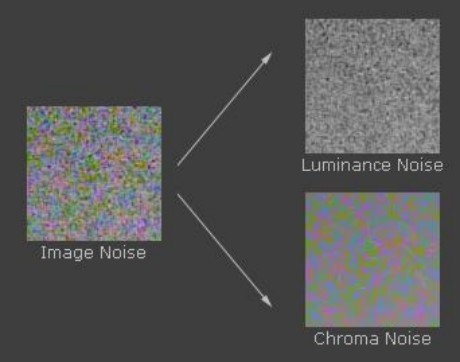

In basso è riportato un esempio di rumore digitale con le sue due componenti dovute a luminanza e crominanza

Come è evidente, il primo si presenta come una sorta di grana più o meno fine, assimilabile al tipico rumore presente nelle pellicole, mentre il secondo è caratterizzato da macchie di colore, anche in questo caso, a grana più o meno grossa che, in alcuni casi, danno all’immagine un’aspetto “blocchettoso”.

E’ chiaro che il rumore dovuto alla crominanza appaia più fastidioso ma il fastidio, come vedremo, dipende anche da un’altro componente, ovverola frequenza. Prima di passare ad esaminare quest’altro aspetto del digital noise, completiamo il quadro relativo a “luma” e “chroma” noise, dicendo che entrambi presentano componenti con pattern variabile nel tempo e, di conseguenza, impossibili da eliminare del tutto.

L’unico accorgimento che si può prendere è quello di cercare di ridurne l’impatto negativo sulla qualità d’immagine. Per farlo nel modo migliore è opportuno separare le componenti di crominanza da quelle di luminanza e trattarle in maniera distinta. L’occhio umano è sensibile alle variazioni relative di intensità luminosa e lo è, in particolare, nelle zone scure

Questo significa che, oltre a compensare la caratteristica lineare di ingresso/uscita mediante l’applicazione di una curva tonale che, sul modello di quella dell’occhio umano, assegni più valori alle parti scure dell’immagine, la fotocamera deve intervenire anche, nelle operazioni di riduzione del rumore, soprattutto nelle zone d’ombra. Inoltre, c’è da tener conto di un altro fattore: l’occhio unano è sensibile ai contrasti ma solo quando questi superano il 2% ed è massima per il bianco e nero.

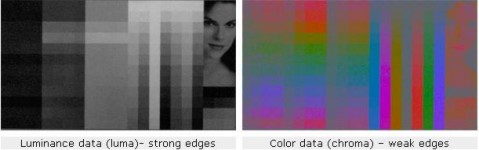

Questo significa che una variazione di colore tra pixel contigui che presentano una più o meno marcata differenza di tipo monocromatico risulterà meno evidente all’occhio rispetto ad una variazione tra zone adiacenti di colore diverso. In altre parole, l’occhio presenta una maggiore sensibilità alle variazioni di luminanza che a quelle di crominanza. La conseguenza è che la componente di luminanza si presenta con bordi e dettagli ben marcati e definiti, mentre quella di crominanza sarà caratterizzata da contorni poco definiti e dettagli difficili da distinguere

Quindi, un algoritmo che si deve occupare di trattare il rumore da “crominanza” e quello da “luminanza” deve occuparsi, nel primo caso, di intervenire preservando il più possibile dettagli e contorni, soprattutto nelle zone più scure dell’immagine, mentre, per la seconda tipologia, può intervenire più pesantemente nella riduzione del rumore senza timore di perdere dettagli fini.

Un altro aspetto di cui tener conto ha, ancora una volta, a che fare con le caratteristiche dell’occhio umano, ovvero la sua maggiore sensibilità alle componenti cromatiche nella banda del verde e del giallo. Una delle misure prese è quella di fare uso di 2 fotositi “verdi” insieme ad uno rosso ed uno blu nei sensori con pattern di tipo bayer; questo permette di avere, sul canale del verde, il doppio delle informazioni rispetto agli altri due.

Poiché il photon shot noise, una delle componenti più importanti del rumore di tipo random pattern, soprattutto ad alti ISO, cresce con la radice quadrata del numero di fotoni incidente, mentre il segnale aumenta linearmente con il numero dei fotoni, questo accorgimento permette di avere un miglior SNR proprio sulla componente cromatica a cui l’occhio umano è più sensibile. In maniera analoga, è possibile ottenere un miglioramento della qualità d’immagine, ad alti ISO, sacrificando un po’ di risoluzione spaziale, grazie alla tecnica del pixel binning.

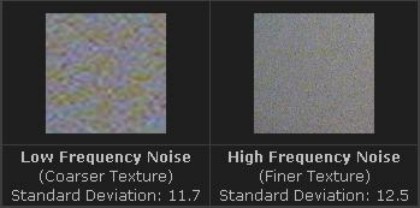

Come accennato in precedenza, un altro aspetto importante è costituito dalla frequenza del rumore stesso. Ciascuno dei vari tipi di rumore digitale esaminati hanno una loro distribuzione in frequenza; questa distribuzione influenza in maniera determinante la percezione del rumore stesso elaborata dal sistema occhio-cervello.

I migliori algoritmi di riduzione del rumore sono quelli che riescono a “spalmare” nella maniera più uniforme il rumore in frequenza, mentre quelli meno efficienti e più economici presentano una distribuzione con densità maggiore alle basse frequenze. Gli algoritmi che distribuiscono in modo più uniforme il rumore in frequenza, permettono il ricorso a filtri meno aggressivi che permettono di preservare i dettagli fini.

Al contrario, algoritmi più “economici” costringomno ad usare filtri più aggressivi, all’aumentare della sensibilità (quindi al salire degli ISO) che finiscono col “piallare” i dettagli fini, per poter contenere gli effetti del rumore.

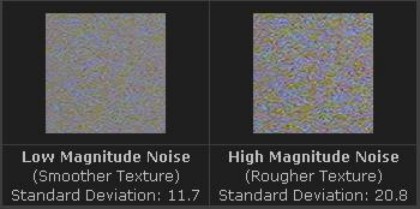

Ultimo aspetto da considerare è che il rumore è un segnale, seppure indesiderato, e come ogni segnale è caratterizzato da una distribuzione in frequenza a da un’ampiezza. Quest’ampiezza influenza direttamente la qualità dell’immagine. Ad ampiezze maggiori corrispondono cifre di rumore più elevate, maggior contrasto tra aree adiacenti, ovvero tutti fenomeni che tendono ad evidenziare ogni possibile elemento riconducibile al rumore digitale. Questo, a parità di tipologia di rumore, di frequenze, ecc, introducono un maggior degrado del segnale stesso

E qui torniamo al punto di partenza, ovvero alla necessità primaria di avere valori di rumore più bassi possibile o, per meglio dire, valori di SNR più favorevoli. Come abbiamo visto nei precedenti articoli, per avere il miglior segnale utile si devono ridurre al minimo tutte le possibili forme di rumore, da quello elettrico alle interferenze tra pixel contigui, a quello derivante dalla distribuzione random dei pochi fotoni catturati dal singolo fotosito, ecc, ma si deve cercare anche di massimizzare la quantità di luce che colpisce ogni singolo fotosito.

Quindi è meglio avere pixel più grandi e meno densi, sistemi più efficienti di microlenti, algoritmi di NR più sofisticati, lenti di qualità superiore. In alcuni casi, per ridurre al minimo i disturbi con pattern temporalmente variabile si prelevano più scatti della stessa immagine e si fa la loro composizione come avviene, ad esempio, in alcuni modelli di Hasselblad, sfruttando il principio che lo shot noise cresce con la radice quadrata e il segnale in maniera lineare con il numero di fotoni incidenti.

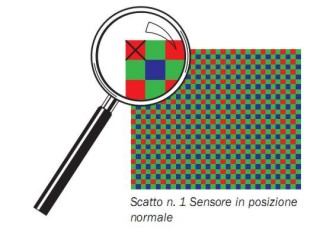

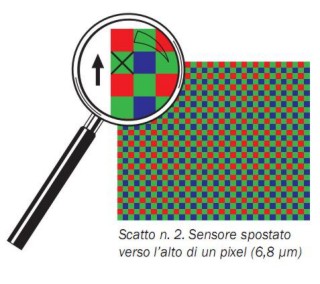

In realtà, il sistema Hasselblad, tra uno scatto e l’altro, sposta anche il sensore dello spazio di un fotosito, per ottenere, ad ogni singolo scatto, che tutti i fotodiodi che compongono un pixel si trovino nelle stesse “condizioni di luce”, questo al fine di ridurre al minimo alcuni tipi di artefatti

Ovviamente,il sistema Hasselblad, di cui ho riportato solo 2 delle 4 posizioni previste in modalità “scatto multiplo” se è ottimo per lo still life non si presta molto bene ad altri tipi di fotografia che richiedono raffiche molto veloci. Altre tecniche si basano sul sovracampionamento dell’immagine, in maniera simile a quanto avviene nele operazioni di antialiasing.

In ogni caso, come si sarà capito, è di fondamentale importanza che ciascun fotosito raccolga la maggior quantità di informazioni possibile e questo, in fotografia, significa il più alto numero di fotoni.

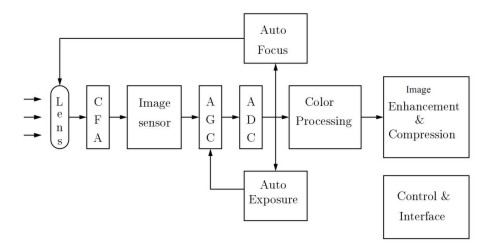

La luce è, dunque, l’elemento fondamentale, la base su cui poggia tutta la successiva elaborazione, come emerge chiaramente anche da questo schema a blocchi di una fotocamera

Al di là delle tecnologie implementate, è basilare conoscere la luce, cercare quella giusta, imparare ad adoperarla, sia essa “naturale” o artificiale, prodotta dal sole o da flash e faretti. Imparare a giocare con essa, creando gli effetti voluti o inventandone di nuovi.

In conclusione, pur essendo tra i più convinti assertori della teoria che un buon mezzo aiuta sia il principiante che il fotografo esperto, sono qui, al termine di una serie di capitoli dedicati agli aspetti tecnologici di un sensore digitale, ad esortare chi legge a mettere da parte le teorie e ad andare a cercare la luce migliore.