Questa settimana ho intenzione di affrontare un argomento spesso fonte di polemiche e discussioni: quello della corsa ai Mpixel nella realizzazione di sensori di fotocamere digitali e cellulari. Il web è disseminato di news come questa o di articoli da blog in cui si dà notizia o si commenta l’adozione di qualche nuovo sensore che incrementa il numero di Mpixel rispetto ai modelli precedenti.

Al di là della ridda di commenti e dei confronti improbabili, come questo, dove si comparano i 50 ISO di un cameraphone contro i 400 di una compatta digitale, la domanda è se esista un approccio al problema, tale da togliere ogni dubbio e da stabilire delle regole certe.

Per sgombrare il campo da ogni equivoco, premetto che, in questa sede, non tratterò le differenze tra le varie tecnologie (CMOS, CCD, NMOS, ecc) o i diversi tipi di matrice dei sensori (bayer, foveon, ….). Non farò neppure una disamina approfondita dei diversi tipi di disturbo ma mi limiterò a prendere in considerazione ciò che limita il potere risolvente, e non solo quello, di un sistema lente-sensore, sia ad ISO alti (rumore) che ad ISO bassi (diffrazione in primo luogo).

Partiamo innanzitutto da una formula, quella che calcola la risolvenza del sistema lente-sensore:

lpmm (totale) = 1/[1/lpmm (sensore) + 1/lpmm (obbiettivo)]

dove lpmm indica la coppia di linee per millimetro. Il motivo per cui si utilizza questa grandezza nel calcolo dei valori di MTF (che è un parametro più complesso in quanto tiene conto anche dei valori di contrasto) è presto detto: il teorema di Shannon prevede che la per la corretta ricostruzione di un segnale campionato siano necessari almeno due campioni per ciclo e questo, riferito ad una matrice ideale di punti, equivale a due pixel contigui.

Dalla formula precedente, appare evidente una cosa: premesso che il potere risolvente di una lente, per quanto buona, non è infinito, la risolvenza dell’intero sistema è inferiore al valore più basso tra i poteri risolventi di ciascuno dei due elementi (in pratica quello del sensore).

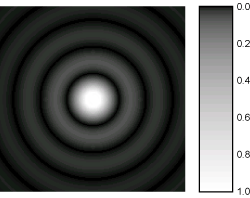

Una lente, alle maggiori aperture presenta fenomeni di aberrazione e distorsione, mentre, quando si inizia a chiudere il diaframma, inizia ad essere affetta dalla diffrazione. Quest’ultima ha origine quando la radiazione incidente ha una lunghezza d’onda comparabile all’apertura della fessura che si trova ad attraversare. Quando si verifica questa condizione, la fessura diventa, a sua volta, origine di segnali che producono sul bersaglio (il sensore, in questo caso) delle frange di interferenza circolari, con una campana più alta al centro, seguita da anelli ad andamento sinusoidale con ampiezza decrescente.

Questa figura, nota come disco di Airy, fornisce la distribuzione della luce (dischi chiari) e delle zone di buio, sul bersaglio. Il cerchio centrale è quello che contiene l’informazione, in forma di fotoni, che il sistema di fotodiodi e circuiti presenti sul sensore, raccoglie e trasforma in segnali elettrici che vengono elaborati dal processore e trasformati in immagini .

Se si immagina di allocare ogni parte centrale di un disco di Airy su ciascun pixel, si possono iniziare a fare delle semplici considerazioni. Consideriamo i seguenti parametri: larghezza e luminosità del disco centrale, distanza tra due di questi dischi, dimensioni del singolo pixel. Si sarà capito, a questo punto, che avere pixel di dimensioni maggiori (che meglio contengono l’area centrale della distribuzione di Airy) e meglio spaziati tra di loro, aiuta a contenere le interferenze tra pixel contigui e aumenta, di conseguenza, la nitidezza dell’immagine (aumentando il contrasto).

Allo stesso modo, avere una minor diffrazione permette di ridurre la larghezza della distribuzione di Airy e a concentrare la maggior parte della luce all’interno del disco centrale.

Poiché, però, la diffrazione, al diminuire del diaframma, è un fenomeno ineliminabile, si deve allora fare in modo che la stessa penalizzi il meno possibile il potere risolvente del sistema. Sono, dunque, importanti, le dimensioni dei singoli pixel e la loro distanza.

Su un approfondito articolo pubblicato da luminous landscape si arriva a concludere che i pixel non dovrebbero essere inferiori a 5 micron (considerando che la diffrazione è funzione della lunghezza d’onda e che la radiazione verde è quella usata come riferimento per la progettazione dei sistemi di elaborazione delle immagini, in quanto è quella a cui l’occhio umano risulta più sensibile). Con tale misura, si arriva a concludere che, se prendiamo come valore di apertura al di sotto del quale iniziamo a ritenere tollerabile l’effetto della diffrazione, quello di f/8, un sensore 4:3 non dovrebbe superare i 10 Mpixel, mentre ci si ferma a 15 per il formato DX, a 35 per il 35 mm e a 70 per il medio formato. Se si scende a valori di apertura inferiori, automaticamente scendono anche le dimensioni minime dei pixel (a f/4, ad esempio, si hanno 2,7 micron).

Sperimentalmente, quanto incide questo limite? Se si confrontano i risultati ottenuti con reflex DX, si nota che, partendo dai 10 Mpixel della EOS 40d, fino ad arrivare ai 15 della EOS 50d, si nota che nella risoluzione orizzontale, quella che in formato 3:2 risulta più difficile da incrementare, si registra un aumento di sole 150 LPH (contro le 400 della risoluzione verticale); aumento che, rispetto ai 12 Mpixel della d300, diventa di sole 50 LPH, ovvero 25 coppie di linee complessive sull’intera immagine.

Quindi, anche sperimentalmente, si verifica che il limite, con le attuali tecnologie, su formato DX, è posto tra i 12 ed i 15 Mpixel. Incrementare ulteriormente la risoluzione, ovvero diminuire le dimensioni dei pixel, porta solo ad un aumento di rumore che limita la nitidezza delle immagini all’aumentare degli iso.

Ma questo sarà argomento di un prossimo post.